自动摘要: 数学基础 1.sigmoid函数特性。 2.概率和似然的区别。 机器学习 1.什么是DBSCAN? 2.什么是梯度消失? 3.什么是dropout? 4.卷积层和池化 ……..

数学基础

- sigmoid函数特性。

- 概率和似然的区别。

机器学习

- 什么是DBSCAN?

- 什么是梯度消失?

- 什么是dropout?

- 卷积层和池化层有什么区别?

编程题:

- python中is和==的区别?

- Python多进程有哪些实现方式?

- pytorch中cuda()作用,两个Tensor,一个加了cuda(),一个没加,相加后很怎样?

实践题:

- 跳台阶问题,每次只能跳1个台阶或者2个台阶,n个台阶共有多少种方式?(可以写伪代码)

参考答案:

原则上,能回答5-6个以上即合格;

数学基础

sigmoid函数特性

定义域为

值域为(0,1)

函数在定义域内为连续和光滑的函数

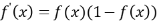

处处可导,导数为

概率和似然的区别

- 概率是指在给定参数

的情况下,样本的随机向量X=x的可能性。而似然表示的是在给定样本X=x的情况下,参数

为真实值的可能性。一般情况,对随机变量的取值用概率表示。而在非贝叶斯统计的情况下,参数为一个实数而不是随机变量,一般用似然来表示。

- 概率是指在给定参数

机器学习

- 什么是DBSCAN?

- DBSCAN是一种基于密度的空间聚类算法,它不需要定义簇的个数,而是将具有足够高密度的区域划分为簇,并在有噪声的数据中发现任意形状的簇,在此算法中将簇定义为密度相连的点的最大集合。

- 什么是梯度消失?

- 在神经网络中,当前面隐藏层的学习速率低于后面隐藏层的学习速率,即随着隐藏层数目的增加,分类准确率反而下降了。这种现象叫做消失的梯度问题。

- 什么是dropout?

- 在神经网络的训练过程中,对于神经单元按一定的概率将其随机从网络中丢弃,从而达到对于每个mini-batch都是在训练不同网络的效果,防止过拟合。

- 卷积层和池化层有什么区别?

卷积层 池化层 特性 权值共享:减少了参数的数量,并利用了图像目标的位置无关性。 稀疏连接:输出的每个值只依赖于输入的部分值。 功能 提取特征 压缩特征图,提取主要特征操作 操作 可惜是二维的,对于三维数据比如RGB图像(3通道),卷积核的深度必须同输入的通道数,输出的通道数等于卷积核的个数。卷积操作会改变输入特征图的通道数。 池化只是在二维数据上操作的,因此不改变输入的通道数。对于多通道的输入,这一点和卷积区别很大。

编程题:

- python中is和==的区别?

- is是用来判断两个变量引用的对象是否为同一个,==用于判断引用对象的值是否相等。可以通过id()函数查看引用对象的地址。

- python多线程?

- 方式一: os.fork()

- 方式二:使用multiprocessing模块:创建Process的实例,传入任务执行函数作为参数

- 方式三:使用multiprocessing模块:派生Process的子类,重写run方法

- 方式四:使用进程池Pool

- pytorch中cuda()作用,两个Tensor,一个加了cuda(),一个没加,相加后很怎样?

- cuda()将操作对象放在GPU内存中,加了cuda()的Tensor放在GPU内存中而没加的Tensor放在CPU内存中,所以这两个Tensor相加会报错。

实践题:

- 跳台阶问题,每次只能跳1个台阶或者2个台阶,n个台阶共有多少种方式?

1

2

3

4

5

6

7

8

9

10int JumpFloor(int target) {

if(target<=1) return target;

int[] a = new int[target+1];

a[1]=1; a[2]=2;

for(int i=3;i<=target;i++){

a[i] = a[i-1] + a[i-2];

}

return a[target];

}